Voir le sommaire Ne plus voir le sommaire

Face à la course mondiale à l’informatique quantique, Google affirme un nouveau cap. Son équipe rapporte un calcul terminé 13 000 fois plus vite qu’un ordinateur classique. Le test reste ciblé, mais il annonce des applications plus concrètes.

Un bond de performance mesuré

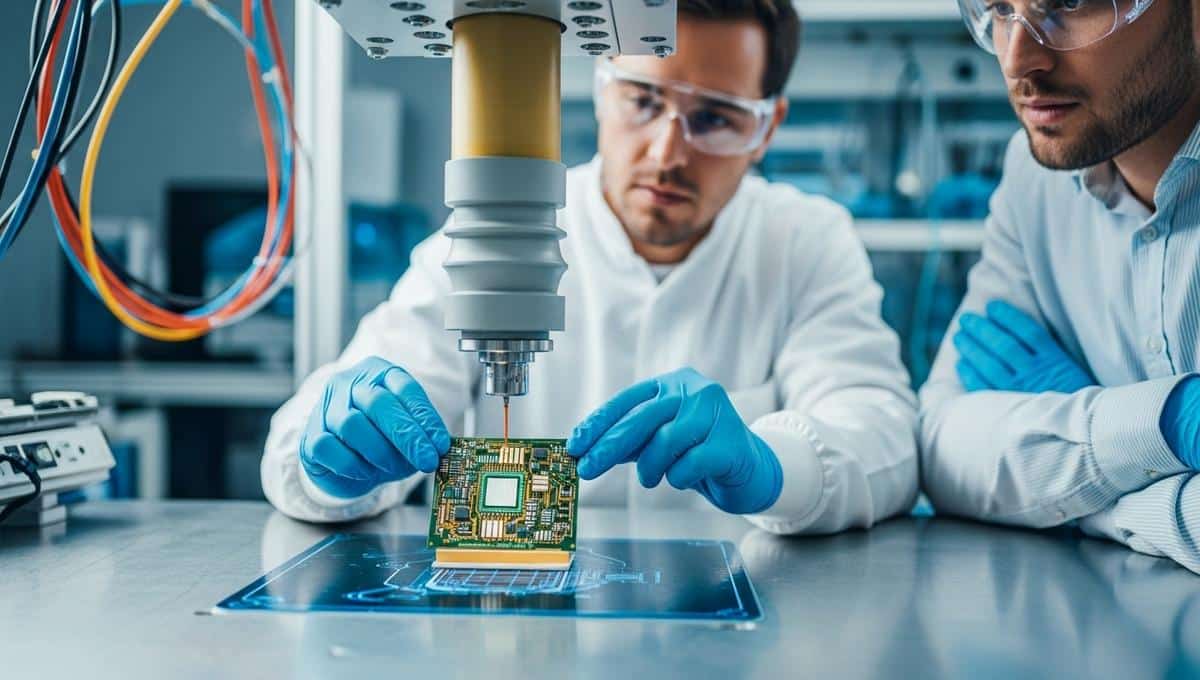

Le protocole utilisé s’appuie sur un banc d’essai connu des physiciens. Ainsi, le processeur quantique réalise un échantillonnage de circuits aléatoires, taillé pour mesurer l’écart de vitesse. De plus, l’équipe de Google décrit une amélioration de fidélité et de calibration. Le résultat tient dans une comparaison contrôlée, avec un modèle classique optimisé.

Ce chiffre de 13 000 n’est pas une promesse générale. Il concerne une tâche précise et bien balisée. Pourtant, ce type de test sert d’indicateur fiable pour suivre la feuille de route. Par conséquent, il éclaire les progrès du matériel et des logiciels.

Que signifie ce gain pour les usages ?

Pourquoi cela compte-t-il pour le public et les entreprises ? D’abord, de tels gains ouvrent la voie à des simulations de matériaux ou de réactions chimiques. Ainsi, des prototypes peuvent sortir plus vite des laboratoires. Google avance prudemment, mais le message est clair pour les ingénieurs.

« Ce n’est pas un ordinateur universel, mais un pas de plus vers des usages concrets. »

Google — Puce Sycamore (Processeur quantique). Depuis les premières démonstrations, ce processeur a servi de référence pour comparer méthodes, bruits et calibrations.

Pour transformer un gain isolé en outil quotidien, plusieurs verrous doivent tomber. En revanche, la correction d’erreurs reste coûteuse en qubits physiques. Aussi, l’optimisation des portes et des lectures sous environnement cryogénique pèse sur le rendement. Enfin, il faut des workloads utiles qui tirent parti des atouts quantiques.

- Type de test et métriques associées

- Niveau de bruit et stratégies de réduction

- Coût énergétique et contraintes de salle blanche

- Cas d’usage pilotes à forte valeur

- Calendrier de validation indépendante

Matériel, algorithmes et lutte contre le bruit

Le cœur du message technique tient dans la réduction des erreurs. Ainsi, des séquences plus longues restent cohérentes, ce qui augmente la profondeur exploitable. De plus, l’équipe de Google indique un contrôle affiné des interconnexions entre qubits. Par conséquent, la puissance effective grimpe sans changer la physique de base.

À découvrirOptimiser l’utilisation de votre Google Pixel : astuces et réglages indispensablesGoogle — Puce Willow (Processeur quantique). Ce design illustre une approche itérative du matériel, avec des choix d’architecture qui visent la stabilité et la répétabilité.

Côté algorithmes, les chercheurs s’appuient sur des circuits qui tolèrent mieux le bruit. Ainsi, le logiciel maximise la valeur de chaque cycle utile. Aussi, des techniques de calibration croisée limitent les biais de mesure. Ce tandem matériel-logiciel donne à Google une base crédible pour préparer des cas d’usage.

Le débat scientifique reste vif, car les méthodes de simulation classique progressent. En revanche, cette compétition tire toutes les équipes vers le haut. Ainsi, la barre de validation se déplace sans cesse. En bref, l’échelle et la transparence des tests deviennent décisives.

Comparaisons avec les ordinateurs classiques

Comment comparer ces chiffres à un PC ou à un serveur ? D’abord, le test cible un calcul où les corrélations quantiques font la différence. Aussi, les estimations tiennent compte des meilleurs simulateurs disponibles. Google insiste sur cette comparabilité pour éviter les illusions marketing.

Dans un cadre industriel, on regarde coût, énergie et latence. Ainsi, le calcul quantique s’insère dans une chaîne hybride qui comprend du GPU et du HPC. De plus, la sécurisation des accès et des données devient un enjeu opérationnel. Google met en avant un modèle de service géré, avec des garde-fous clairs.

Que retenir pour les décideurs et les curieux

Pour les responsables R&D, le signal est simple : préparer des preuves de concept ciblées. Ainsi, des équipes peuvent tester des sous-problèmes à faible risque. Aussi, un partenariat avec un fournisseur capable d’auditer ses résultats apporte de la confiance. Google se sait attendu sur ce terrain de la vérifiabilité.

Pour le grand public, l’idée à retenir tient dans la nuance. Oui, certaines tâches voient déjà une accélération x13 000 sur une puce spécialisée. En revanche, le PC de la maison ne devient pas obsolète demain. Google parle d’un progrès graduel, qui pourrait toucher la chimie, la finance et la logistique.

À découvrirGoogle alerte: une nouvelle génération de malwares dopés à l’IA déjoue les protections et accélère les cyberattaquesReste la question du calendrier. Désormais, les jalons porteront sur des tâches applicatives vérifiées par des tiers. Ainsi, chacun pourra juger de la valeur métier, au-delà du chiffre brut. Dans ce cadre, Google devra publier des protocoles reproductibles et des métriques compréhensibles.

Crédit photo © LePointDuJour